Un errore nei sistemi di moderazione di Meta ha causato un'ondata di contenuti violenti nei feed Reels di Instagram, con post che mostravano immagini esplicite non adatte al pubblico. Dopo numerose segnalazioni da parte degli utenti, l'azienda ha confermato di aver risolto il problema e si è scusata per l'incidente.

"Abbiamo corretto un errore che ha portato alcuni utenti a vedere contenuti nei loro Reels che non avrebbero dovuto essere raccomandati. Ci scusiamo per l'errore", ha dichiarato un portavoce di Meta.

L'incidente ha generato allarme tra gli utenti, con molti che hanno riferito di aver visto contenuti espliciti nonostante l'attivazione del filtro "Contenuti Sensibili" al massimo livello.

Come funziona la moderazione di Meta?

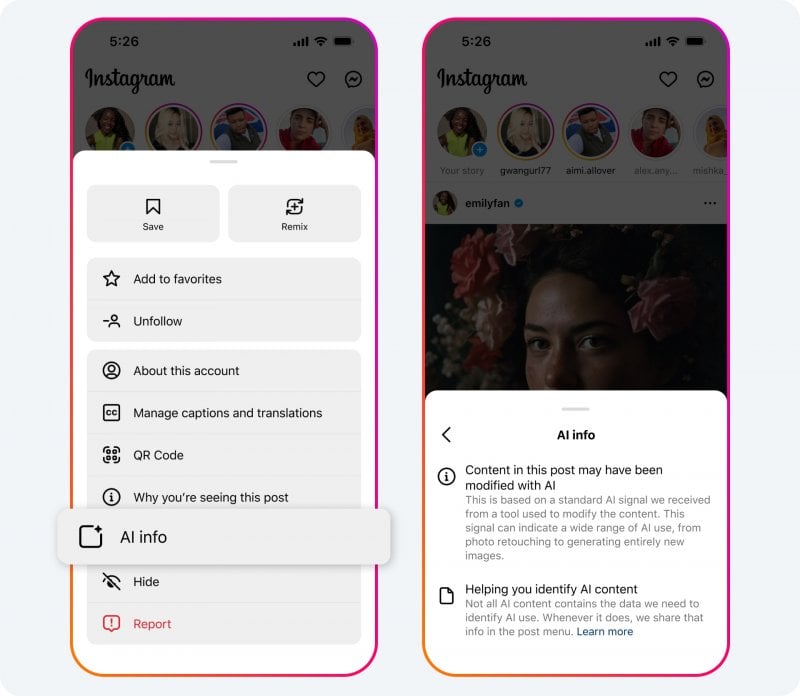

Meta afferma di utilizzare un mix di intelligenza artificiale e revisione umana per individuare e rimuovere immagini disturbanti prima che gli utenti le segnalino. La piattaforma conta su un team di oltre 15.000 revisori per il controllo dei contenuti, supportati da sistemi di AI capaci di identificare materiale violento, nudità e contenuti inappropriati.

Secondo la policy di Meta, sono vietati contenuti come:

- Video che mostrano smembramenti, corpi carbonizzati o lesioni gravi

- Commenti sadici su immagini di sofferenza umana o animale

Tuttavia, la piattaforma consente la pubblicazione di contenuti grafici legati a temi di denuncia sociale, come abusi sui diritti umani o conflitti armati, con limitazioni e avvisi di contenuto sensibile.

Meta cambia rotta: meno censura e più libertà di espressione

L'incidente arriva in un momento delicato per Meta, che di recente ha annunciato una revisione delle sue politiche di moderazione per ridurre la censura e favorire la libertà di espressione. Dal 7 gennaio 2025, la società ha implementato un nuovo approccio, riducendo l'uso di sistemi automatizzati per bloccare i contenuti e concentrandosi solo su violazioni gravi, come terrorismo, sfruttamento minorile, truffe e frodi, droghe e reati finanziari.

Per violazioni minori, Meta ha deciso di affidarsi alle segnalazioni degli utenti, anziché applicare blocchi automatici. Inoltre, la piattaforma ha ridotto la penalizzazione dei post basata su previsioni di possibili violazioni, eliminando gran parte dei depotenziamenti automatici dei contenuti.