OpenAI ha annunciato il lancio di GPT-4o mini, il suo modello di linguaggio di piccole dimensioni più economico e accessibile. Questo nuovo modello si propone di democratizzare l'accesso all'IA, rendendola più conveniente per un'ampia gamma di applicazioni.

GPT-4o mini si distingue per le sue prestazioni superiori rispetto a GPT-3.5 Turbo e ad altri modelli simili, sia in termini di intelligenza testuale sia di ragionamento multimodale. Il modello supporta la stessa gamma di lingue di GPT-4o e offre un miglioramento significativo nelle prestazioni con lunghi contesti rispetto a GPT-3.5 Turbo.

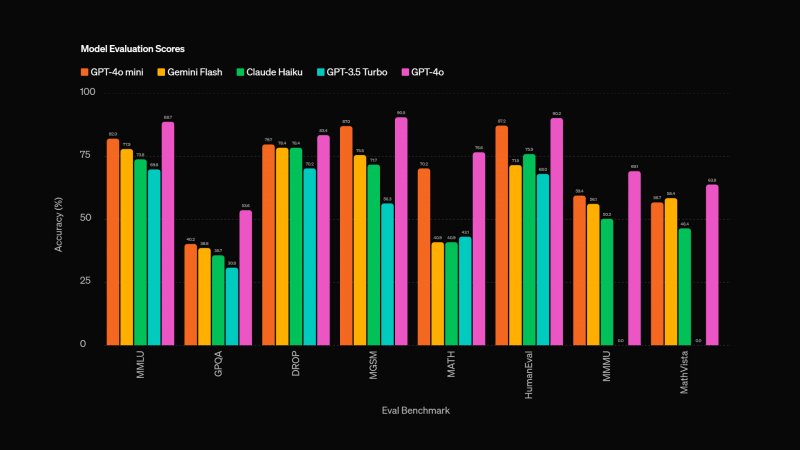

Inoltre, GPT-4o mini eccelle nel ragionamento matematico e nelle attività di codifica, superando i precedenti modelli di piccole dimensioni. I test condotti su benchmark come MMLU, MGSM e HumanEval dimostrano le sue capacità superiori in diverse aree. Per fare un esempio, ha ottenuto un punteggio dell'82,0% su MMLU, un benchmark di intelligenza testuale e ragionamento, rispetto al 77,9% di Gemini Flash e al 73,8% di Claude Haiku.

GPT-4o mini è progettato per essere versatile e adatto a un'ampia gamma di applicazioni, grazie al suo basso costo e alla bassa latenza. Il modello è ideale per applicazioni che richiedono chiamate multiple al modello, l'elaborazione di grandi quantità di contesto o risposte rapide in tempo reale. Ha poi una "conoscenza" sui fatti aggiornata fino a ottobre 2023 e una finestra di contesto di 128K token, ma in outuput supporta solo fino a 16K token per richiesta.

GPT-4o mini è disponibile come modello di testo e visione nelle API Assistants, Chat Completions e Batch. OpenAI ha anche lavorato per migliorarne la sicurezza, applicando nuove tecniche basate sulla ricerca e implementando misure di sicurezza fin dalle prime fasi dello sviluppo. Il modello è stato valutato da oltre 70 esperti esterni per identificare e mitigare potenziali rischi.

Il costo è di 15 centesimi per milione di token in input e 60 centesimi per milione di token in output. Insomma è significativamente più conveniente rispetto ai modelli precedenti, visto che parliamo di un prezzo oltre il 60% più basso rispetto a GPT-3.5 Turbo. Voi che cosa ne pensate? State già usando l'IA in modo intensivo oppure non vi interessa particolarmente?