L'avvento di nuovi e potenti modelli di intelligenza artificiale cosiddetti, come ChatGPT di OpenAI o Gemini di Google, ha portato con sé una serie di interrogativi sulla loro reale efficacia. Le aziende che sviluppano queste tecnologie, infatti, spesso forniscono dati sulle prestazioni dei loro modelli senza un controllo indipendente, basandosi sulla fiducia degli utenti.

Epoch AI, un istituto di ricerca statunitense, si propone di cambiare questo scenario. Guidato da Jaime Sevilla, ricercatore specializzato in IA, Epoch AI ha creato l'AI Benchmarking Hub, una piattaforma online che offre una valutazione imparziale e trasparente delle capacità dei modelli di IA. Ma come funziona l'AI Benchmarking Hub?

L'l'AI Benchmarking Hub

L'l'AI Benchmarking Hub utilizza benchmark specifici per testare le capacità dei modelli di IA in diversi ambiti. Attualmente, la piattaforma si concentra su due benchmark principali:

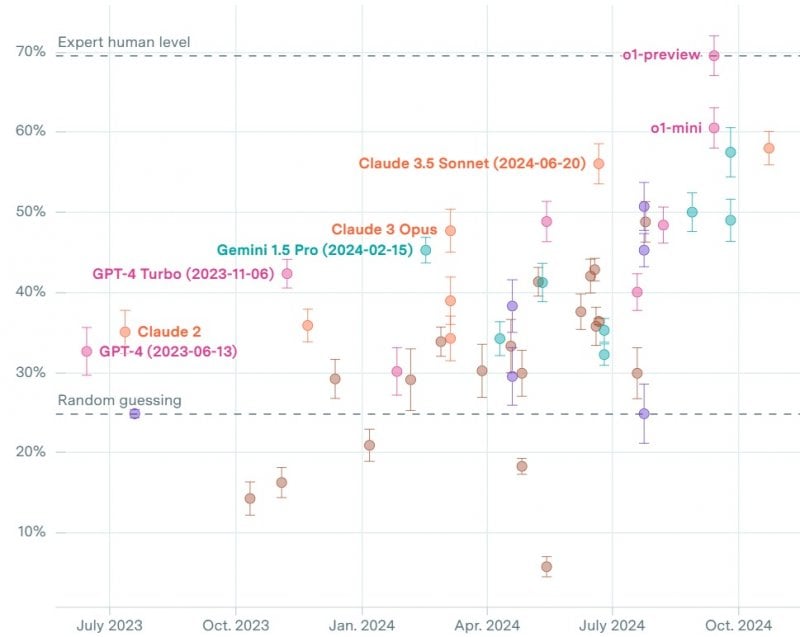

- GPQA Diamond: un test a scelta multipla con domande di livello universitario in biologia, fisica e chimica, che valuta la capacità dei modelli di IA di rispondere a quesiti complessi in ambiti scientifici.

- Math Level 5: un insieme di problemi matematici di alto livello, provenienti da diverse competizioni, che misura l'abilità dei modelli di IA nel risolvere problemi matematici complessi.

I risultati dei test vengono presentati attraverso grafici interattivi, facilmente consultabili da ricercatori, sviluppatori e utenti. Questo approccio trasparente permette di confrontare le prestazioni dei diversi modelli in modo oggettivo, andando oltre le dichiarazioni delle aziende produttrici.

Qual è la migliore IA?

I test condotti da Epoch AI hanno già portato ad alcune interessanti osservazioni. Ad esempio, il modello o1-preview di OpenAI, pur essendo tra i più avanzati, ha ottenuto nel GPQA Diamond un punteggio pari a quello degli esperti umani, inferiore a quanto dichiarato dall'azienda.

Nel benchmark Math Level 5, invece, o1-mini di OpenAI si è distinto per le sue elevate capacità matematiche, seguito da o1-preview e Gemini 1.5 Pro di Google. Un risultato sorprendente è stato ottenuto da Qwen2.5-72B di Alibaba, che si è posizionato al quarto posto.

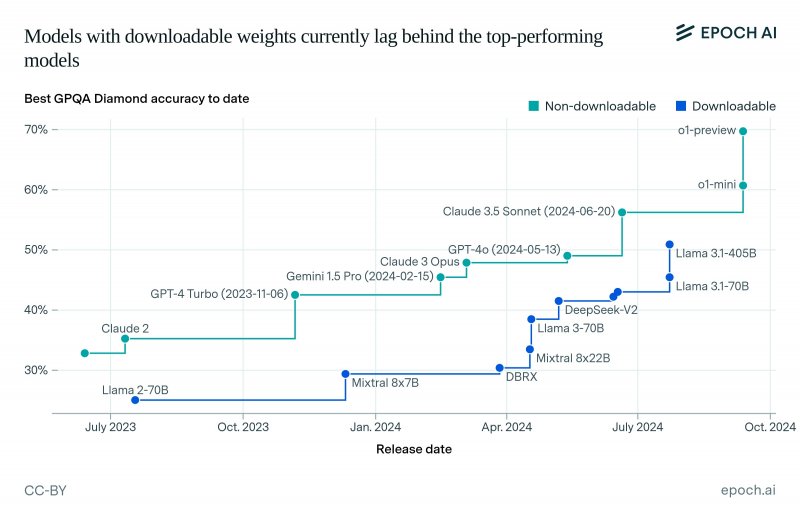

Epoch AI sta inoltre analizzando le differenze di prestazioni tra i modelli scaricabili e quelli non scaricabili, evidenziando come i secondi, guidati da Llama 3.1-405B, stiano faticando a tenere il passo.

In futuro, Epoch AI prevede di ampliare l'AI Benchmarking Hub includendo nuovi benchmark e testando un numero sempre maggiore di modelli. Questo permetterà di avere un quadro ancora più completo e accurato del panorama dell'IA, favorendo lo sviluppo di tecnologie sempre più avanzate e affidabili.

Voi che cosa ne pensate di questa iniziativa? Trovate utile avere degli organi indipendenti per la valutazione delle IA? Diteci la vostra nei commenti qua sotto. A proposito di IA, comunque, Google ha ora un sito con scacchi generati dall'IA e lavora a un nuovo bot di Gemini.