Siamo nell'aprile del 1993: in una tavola calda ai margini di San José, un Denny's nei pressi del cavalcavia Berryessa, tre ingegneri scambiano idee di fronte a omelette, bistecche e una tempesta di caffè. Uno di loro è Jen-Hsun "Jensen" Huang, direttore CoreWare di LSI Logic e designer dei microprocessori di AMD; il secondo è Chris Malachowsky, ingegnere di casa in Sun Microsystems; l'ultimo è Curtis Priem, la mente dietro alcuni dei chip grafici di IBM e Sun Microystems. Un trio d'innovatori che s'incontrano spesso nel cuore dell'allora malfamato quartiere nella periferia est di San José, ai margini di Sunnyvale, discutendo delle più moderne derive inseguite dall'industria dei computer.

Un caffè dietro l'altro, si convincevano sempre più che il calcolo basato sulla grafica avrebbe rappresentato il futuro, e al contempo stavano osservando con grande interesse l'evoluzione dell'industria dei videogiochi, stregati dai crescenti guadagni del settore e dalla comparsa di problemi totalmente inediti sul fronte dell'hardware. Quelle che erano semplici conversazioni, il 5 aprile del 1993, sfociarono nella fondazione di NVIDIA - crasi delle parole Invidia e Video - una piccola società costruita con un investimento iniziale di soli 40.000 dollari.

Oggi, trent'anni più tardi, NVIDIA Corporation è uno dei maggiori colossi della tecnologia, un'azienda leader nel settore delle GPU, delle API e dei SoC, un perno fondamentale nelle filiere produttive legate all'intelligenza artificiale. Videogiochi, ingegneria, costruzione, industria automobilistica: nella nostra contemporaneità, non c'è praticamente settore radicato anche solo parzialmente nell'informatica che non faccia utilizzo di tecnologie emerse dai laboratori della casa, pronte a spingere vicino al limite consentito tanto l'elemento grafico quanto il calcolo parallelo.

Ecco la storia di NVIDIA e il tortuoso percorso che ha portato dalla fondazione fino all'emersione delle GeForce RTX 40 Series.

Gli inizi

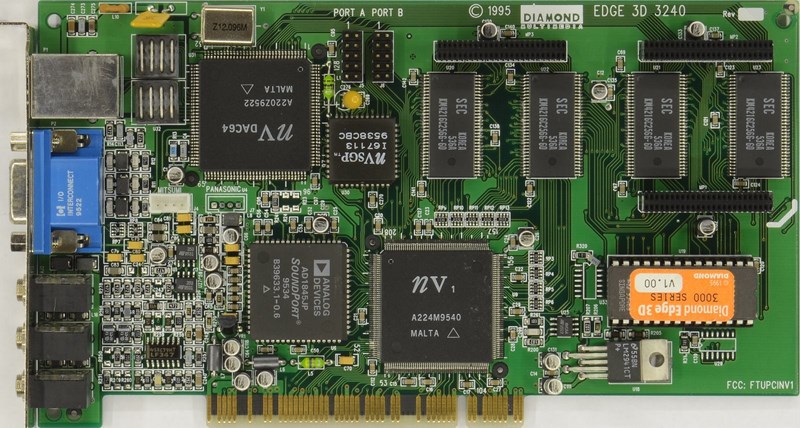

La storia embrionale di NVIDIA vive dell'intreccio con i primi progetti "NV", acronimo di "Next Version" che sarebbe diventato parte integrante della storica denominazione della compagnia. Il primo prodotto a vedere la luce del sole fu proprio il chipset NV1, praticamente il primo acceleratore multimediale completo: l'architettura ospitava un processore grafico, una scheda audio integrata e persino una porta gamepad, compatibile con la variante per SEGA Saturn. L'unica ragione per cui il nome di NV1 resta tutt'oggi associato a un passato esoterico risiede nella sfortunata scelta di scommettere sulle texture quadratiche invece che sui poligoni, che come ben noto avrebbero trovato decisamente maggiore risposta. L'altalenante andamento del Saturn non aiutò certo la diffusione, ma l'ultimo chiodo nella bara del progetto - quello capace di tarpare definitivamente le ali anche al potenziale successore - fu piantato da Microsoft tramite l'emersione delle prime DirectX, orientate esclusivamente verso la tecnologia di rendering a poligoni.

Tra il 1997 e il 1998 la concorrenza era serrata, bisognava cambiare qualcosa, e tale cambiamento avrebbe dovuto passare - oltre che dall'ormai inevitabile matrimonio con i poligoni - anche dall'abbandono dell'idea di processore multimediale integrato, che si risolse nella rimozione dal circuito stampato tanto del sottosistema audio quanto del supporto al controller. Se 3dfx era uno dei produttori leader di tale mercato grazie all'ambito Voodoo, con Riva 128 NVIDIA diede un violento colpo di coda al settore, supportando già dal momento del lancio risoluzioni più elevate rispetto alla concorrenza. Tale filosofia si cristallizzò nel lancio di Riva 128ZX, che ampliava la RAM a 8Mb e integrava miglior supporto a OpenGL. La grande differenza, tuttavia, la fecero i driver, costantemente affinati e pronti a risolvere tempestivamente qualsivoglia problema di compatibilità. Tutta l'esperienza dei primi giovani anni, d'altro canto, sarebbe servita esclusivamente per mettere NVIDIA al centro dei radar del mercato.

La prima GPU e l'espansione

Negli anni successivi l'affinamento della filiera e quello relativo ai PCB portarono al tanto agognato superamento di 3dfx, e anche se l'industria restava gremita di competitor agguerriti, NVIDIA era ormai una soluzione più che tenuta in considerazione, vicina al 24% dello share di mercato. La grande svolta giunse solamente l'11 ottobre del 1999, data che coincise con la prima commercializzazione della GeForce 256, accompagnata dall'inusuale definizione di "prima GPU al mondo". A onor del vero si trattava di un termine già esistente, ma fu popolarizzato dalla casa al fine di indicare: "Un singolo chip con motori integrati per trasformazione, illuminazione e rendering capace di processare un minimo di 10 milioni di poligoni al secondo". Più d'ogni altra cosa, lo spostamento del calcolo dei triangoli dalla CPU alla GPU - capace di oltrepassare la concorrenza sul fronte hardware - assieme calo della complessità delle architetture, portarono a un abbattimento dei prezzi del settore, aprendo alla società anche il sentiero del mercato CAD, ovvero quello orientato verso il design, e portando all'emersione della prima linea Quadro.

Lo strepitoso successo dei prodotti NVIDIA seppe farsi notare e catturò in particolar modo l'attenzione di Microsoft, che affidò proprio alla compagnia il compito di progettare e costruire l'hardware grafico della sua nuova console per videogiochi, ovvero Xbox. Al di là dei traguardi raggiunti sul fronte tecnico, tale accordo con la casa di Redmond iniettò 200 milioni di dollari nelle casse di NVIDIA, una somma che fu immediatamente impiegata per inseguire l'espansione. La prima acquisizione risale al 2000 e fu proprio quella di 3dfx, storico sviluppatore delle Voodoo ormai costrette all'inseguimento di GeForce; nel corso degli anni successivi, il medesimo destino toccò a ExLuna, MediaQ, iReady, Hybrid Graphics e soprattutto alla controversa ULI Electronics, che all'epoca era uno dei più grandi fornitori di ATI Technologies, il più affermato competitor della casa di Santa Clara. Non deve stupire che nel 2006 tanto NVIDIA quanto AMD - la società che aveva da poco rilevato ATI - si trovarono al centro di un'indagine del Dipartimento di Giustizia statunitense per ipotetiche violazioni in materia di antitrust. NVIDIA, dal canto suo, ormai aveva mani dappertutto: a partire dal 2004 avrebbe aiutato Sony nella costruzione dell'RSX per PlayStation 3 senza occuparsi della produzione diretta, mentre quattro anni più tardi integrò nella sua struttura anche Ageia, ben noto sviluppatore del motore fisico PhysX.

Progetti collaterali e limiti imposti

Nel tentativo di espandere il peso della sua tecnologia GPU, già nel 2004 NVIDIA aveva sviluppato CUDA, un'architettura hardware per l'elaborazione parallela, una soluzione che mirava a sostituire le librerie grafiche tridimensionali con la programmazione diretta dell'unità grafica al fine di premiare il calcolo parallelo. Usando CUDA, di fatto, le ultime GPU NVIDIA diventano architetture aperte come le CPU. Allo stesso modo, nel 2008, la compagnia ha sorpreso il mondo attraverso la presentazione della prima linea Tegra, dei SoC che combinavano CPU con architettura ARM con unità di elaborazione grafica. Lo scopo del progetto era evidentemente quello di penetrare con decisione il mercato di tablet, smartphone e MID, ma non bisogna dimenticare che tale deriva è quella che ha portato anche all'integrazione del Tegra X1 nell'architettura di Nintendo Switch all'alba del 2017, all'epoca una delle più grandi prove nel contesto dei dispositivi mobili.

Anche se allora NVIDIA era determinata a proseguire la sua strategia fortemente improntata all'integrazione, in seguito alla mattanza dei 2000 gli sguardi della mano visibile del mercato erano strettamente puntati su di lei. Dopo l'acquisizione di Mellanox Technologies e delle sue DPU, apparentemente sottratte a Intel con il raggiungimento di un accordo prossimo ai 7 miliardi, il tentativo di acquisizione di ARM del 2020 si risolse in diciotto lunghi mesi di disquisizioni che portarono le autorità antitrust, in particolar modo quella del Regno Unito, a opporre una strenua resistenza, quella che al momento sembra aver posto un punto fermo in fondo alla tattica d'acquisizione e integrazione indiscriminata portata avanti dalla casa.

L'età dell'oro e le criptovalute

L'interezza dei 2000 è stata costellata di prodotti GeForce volti al miglioramento costante e caratterizzati dall'emersione continua di nuove architetture. Alcuni momenti salienti risiedono nel lancio della serie FX, la prima a guardare al passato oltre che al futuro portando a un età dell'oro dell'ecosistema retro, e la discussa GeForce 8 Series, costruita sulla nuova architettura Tesla nonché prima GPU capace di offrire supporto completo a Direct3D 10. Dopo il breve exploit della micro-architettura Fermi, la casa giunse a un nuovo punto di svolta nel 2010 con l'adozione della Kepler, e solo nel 2012 riuscì finalmente a riposizionarsi dinanzi a AMD dopo qualche anno di quiete forzata.

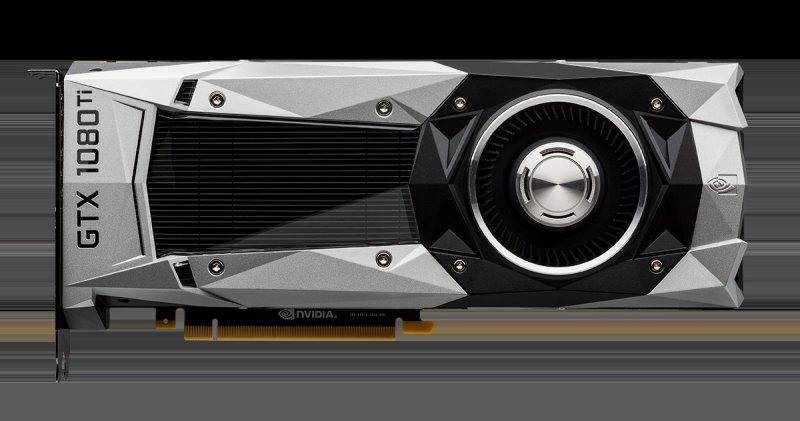

Ciò accadde indubbiamente per merito della GTX 680, probabilmente una delle migliori GPU mai realizzate dalla casa, superiore in tutto e per tutto rispetto alla più impegnativa proposta della concorrenza. Tale successo fu replicato nel 2014 con la GTX 980, scheda capace di inaugurare di per sé un periodo di dominanza culminato con il lancio della GeForce GTX 1080, nel 2016. Si tratta probabilmente dell'unica GPU della storia a non aver avuto alcun concorrente al di fuori di sé stessa: era il 30% più veloce della 980 Ti, costava meno, e soprattutto non temeva le incursioni dalle parti di AMD, spalancando un baratro che al giorno d'oggi sembra impossibile da replicare.

Nel 2016, tanto NVIDIA quanto AMD - ma soprattutto i consumatori - furono investiti dagli effetti collaterali del boom delle criptovalute. I minatori di Bitcoin, nello specifico, giunsero alla realizzazione che le GPU fossero estremamente "efficienti" - si fa per dire, in termini energetici - nel mining di criptovalute, portando alla costruzione di larghi impianti e sistemi talmente diffusi da causare un'inaspettata carenza di schede grafiche; l'impennata nella domanda, che sarebbe ulteriormente esplosa a seguito della pandemia globale, portò un violento terremoto nel mercato i cui strascichi si percepiscono ancora oggi, fra prezzi esorbitanti e pezzi estremamente difficili da trovare persino sugli scaffali dei negozi digitali.

L'ultima grande "milestone" nella storia di NVIDIA coincide con l'introduzione della piattaforma RTX, il cui DNA avrebbe dovuto risedere nel ray tracing in tempo reale. Dopo la serie di successi culminati nel dominio della GTX 10 series, la società concentrò gli sforzi nella direzione del ray tracing e dell'upscaling via IA, sacrificando di converso la performance generale delle schede commercializzate. Oggi l'impatto di tecnologie come il DLSS vive sotto gli occhi di tutti i videogiocatori, ma allora le cose andarono in modo diverso. Numerosi analisti hanno teorizzato che si trattasse di un tentativo per rendere irrilevanti le Radeon finché non avessero anch'esse integrato le succitate tecnologie, ma le differenze di cruda performance rispetto alle linee precedenti si dimostrarono decisamente basse al netto di prezzi oltremodo lievitati, spianando la strada alla decisa risalita della concorrenza. La tanto attesa correzione del tiro giunse infine nel 2020, tuttavia il confronto fra la RTX 3080 - scheda in sé e per sé eccellente - e la RX 6800 XT di AMD si dimostrò bilanciato come difficilmente era stato in passato. L'eccitazione per tale sfida, in ogni caso, era destinata ad esaurirsi molto velocemente, perché nel pieno dei lockdown il pubblico dovette giungere rapidamente alla triste realizzazione che sarebbe stato quasi impossibile accaparrarsi una GPU. Tale realizzazione è sopravvissuta in tempi recenti, laddove spesso si lamenta la spinta riservata all'apparato software al netto di un incremento dei prezzi che ai più appare ingiustificato.

NVIDIA oggi

Le incursioni di NVIDIA nel mondo gaming, dopo averla portata a collaborare e maturare esperienza con tutti i grandi del settore, da Xbox passando per PlayStation fino a Nintendo, si sono sviluppate nella linea di console SHIELD, fino a raggiungere l'attuale consacrazione per mezzo di GeForce NOW, sistema di Cloud Gaming ora fra i più importanti e performanti in circolazione. Se negli ultimi anni abbiamo assistito alla nascita di progetti accattivanti come Minecraft RTX, e gli sforzi in materia di architetture portatili potrebbero portare evoluzioni inaspettate, resta estremamente difficile prevedere con cognizione di causa le prossime direzioni intraprese dalla casa. Ovviamente l'impegno nell'ambito GPU procede come di consueto, e giusto negli ultimi mesi ha visto luce l'attesa GeForce 40 Series costruita su architettura Ada Lovelace; al momento, l'RTX 4090 è emerso come il chip più veloce per il mercato mainstream, mentre si ipotizza che entro il 2024 faccia il suo esordio una nuova mostruosa Titan RTX o per lo meno una RTX 4090 Ti.

Oggi NVIDIA è un'impresa da 10 miliardi di dollari di fatturato che continua ad esercitare una strategia pionieristica, non solo in ambito videoludico e nel settore delle schede grafiche, ma anche in termini di ricerca scientifica, di intelligenza artificiale e di impatto su dozzine di mercati fra i più grandi del pianeta. Insomma, la storia di NVIDIA vive dell'intreccio con il mondo dei videogiochi e nel corso degli ultimi trent'anni la crescita della tecnologia è stata profondamente segnata dal suo passaggio, a prescindere dalle deviazioni degli ultimi anni. Anche se di recente la curva dell'evoluzione si è enormemente appiattita, e strumenti come il ray tracing non sono stati in grado di rappresentare il tanto atteso grande balzo generazionale, se c'è una fucina alla quale è necessario prestare costantemente attenzione è proprio quella di Santa Clara.