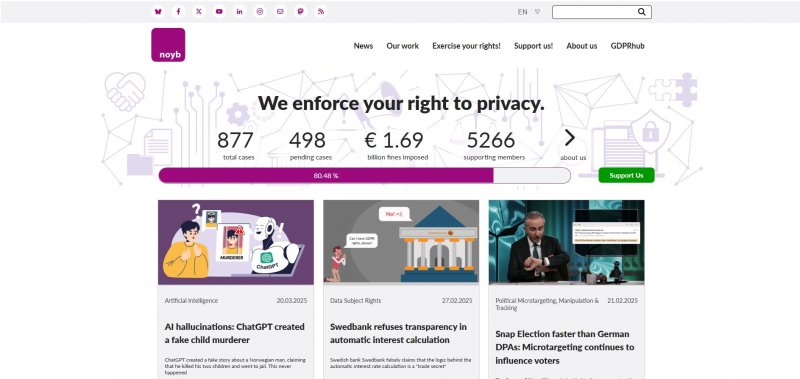

OpenAI si trova nuovamente sotto i riflettori in Europa a causa di una denuncia per violazione della privacy legata alle famigerate "allucinazioni" di ChatGPT, ovvero la tendenza del modello a inventare informazioni errate. Il caso, supportato dall'organizzazione per i diritti digitali Noyb, riguarda un uomo norvegese che ha scoperto che ChatGPT lo aveva erroneamente accusato di un crimine atroce: l'omicidio dei suoi due figli e il tentato omicidio del terzo.

Questo episodio solleva gravi questioni sulla responsabilità legale di OpenAI e sull'applicabilità del Regolamento generale sulla protezione dei dati (GDPR) ai modelli di intelligenza artificiale generativa. Le conseguenze per l'azienda potrebbero essere sanzioni pesanti e l'obbligo di modificare radicalmente il funzionamento di ChatGPT.

Un’accusa gravissima: ChatGPT diffama un uomo innocente

Secondo quanto riportato da Noyb, ChatGPT ha fornito informazioni completamente false sull'uomo, sostenendo che fosse stato condannato a 21 anni di carcere per aver ucciso i suoi figli. Sebbene il chatbot abbia riportato alcuni dettagli corretti, come il nome dell'uomo, il numero e il genere dei suoi figli e la sua città di residenza, il resto della narrazione è stato completamente inventato.

Il problema non è nuovo: sono già emersi diversi casi in cui ChatGPT ha fornito informazioni errate e potenzialmente dannose su individui, incluso un giornalista tedesco accusato di abusi su minori e un politico australiano coinvolto in uno scandalo di corruzione inesistente.

"Il GDPR è chiaro: i dati personali devono essere accurati," ha dichiarato Joakim Söderberg, avvocato specializzato in protezione dei dati presso Noyb. "Se non lo sono, gli utenti hanno il diritto di correggerli. Mostrare un semplice disclaimer che avverte che ChatGPT può sbagliare non è sufficiente. Non si può diffondere informazioni false e poi aggiungere una nota che dice che potrebbero non essere vere."

Le implicazioni legali: ChatGPT può essere ritenuto responsabile?

Secondo il GDPR, OpenAI, in quanto sviluppatore di ChatGPT, è legalmente obbligata a garantire che i dati personali trattati dall'intelligenza artificiale siano esatti e aggiornati. Il fatto che l'azienda non offra agli utenti la possibilità di correggere le informazioni sbagliate generate dal modello è una potenziale violazione del regolamento.

Se le autorità per la protezione dei dati confermassero la violazione, OpenAI potrebbe affrontare multe fino al 4% del fatturato globale, una cifra che potrebbe ammontare a diverse centinaia di milioni di dollari.