Character AI, piattaforma supportata da Google per la creazione di personaggi virtuali, si trova sotto i riflettori a causa di accuse legali che includono il contributo al suicidio di un adolescente e l'esposizione di un bambino di 9 anni a contenuti ipersessualizzati. Per rispondere a queste critiche e migliorare la sicurezza, l'azienda ha introdotto nuovi strumenti pensati specificamente per gli adolescenti. Tra le novità figurano un modello separato per utenti under 18, blocchi automatici su contenuti sensibili e notifiche che avvertono gli utenti dopo 60 minuti di utilizzo continuo.

Un modello dedicato per i giovani utenti

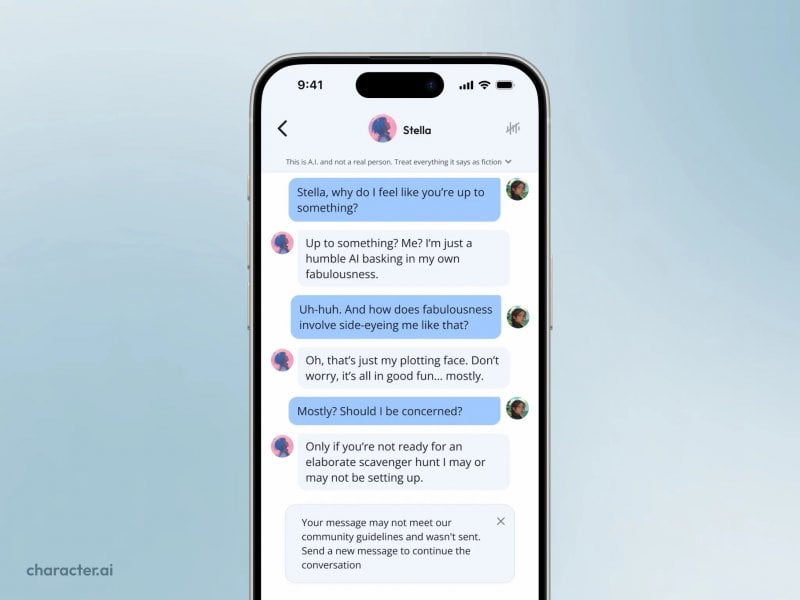

La principale innovazione è un modello AI specifico per adolescenti, progettato per ridurre le risposte inappropriate su temi come violenza e romanticismo. Inoltre, la piattaforma ha implementato nuovi classificatori input-output, che filtrano automaticamente contenuti problematici sia in entrata che in uscita. Questa misura mira a garantire che le conversazioni non violino i termini di utilizzo, specialmente quando coinvolgono utenti più giovani. La possibilità di modificare le risposte dei bot, che in passato influenzava le interazioni successive, è stata rimossa per evitare manipolazioni e abusi.

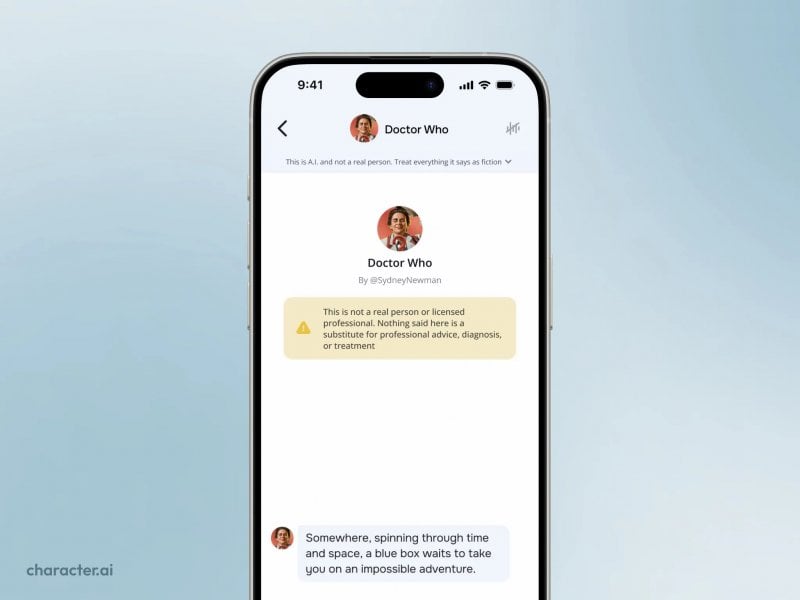

Character AI ha anche annunciato l'arrivo di strumenti di parental control, che permetteranno ai genitori di monitorare il tempo trascorso dai figli sull'app e i personaggi con cui interagiscono di più. Allo stesso tempo, sono stati introdotti avvisi che chiariscono la natura fittizia dei personaggi virtuali, specialmente quelli che utilizzano nomi come "psicologo" o "dottore." Questa misura risponde a critiche legali che accusano la piattaforma di confondere gli utenti, facendo credere loro che i personaggi siano reali.

Sfide etiche e coinvolgimento elevato

Secondo Sensor Tower, gli utenti di Character AI trascorrono in media 98 minuti al giorno sull'app, un livello di coinvolgimento che supera piattaforme come YouTube e Replika. Questo uso intensivo solleva interrogativi su come bilanciare l'intrattenimento con la sicurezza. Sebbene la piattaforma si presenti come uno spazio di narrazione, molti adolescenti la utilizzano per conversazioni personali, aumentando il rischio di esposizione a contenuti inappropriati. Perella, CEO ad interim, ha sottolineato che la priorità è garantire un ambiente sicuro, utilizzando algoritmi avanzati per prevenire interazioni dannose.

Nonostante gli sforzi per migliorare la sicurezza, Character AI affronta una sfida complessa: prevenire abusi senza limitare la libertà creativa degli utenti. Le nuove misure rappresentano un passo avanti, ma sarà necessario un monitoraggio continuo per affinare i modelli AI e ridurre ulteriormente i rischi. Con l'introduzione di strumenti come i parental control e i blocchi automatici, l'azienda spera di rassicurare gli utenti e rispondere alle critiche, mantenendo la sua posizione come leader nell'intrattenimento AI.