Google ha ufficialmente lanciato in anteprima Gemini 2.5 Flash, l'ultima evoluzione del suo modello AI disponibile tramite l'API Gemini, Google AI Studio e Vertex AI. Costruito sulla base del successo di Gemini 2.0 Flash, questo nuovo modello introduce un'importante novità: la possibilità di attivare o disattivare il "ragionamento" per adattare la qualità della risposta al budget, alla latenza e alle esigenze di precisione. L'obiettivo è semplice ma ambizioso: mantenere i costi bassi e le prestazioni elevate, anche per compiti complessi.

Cos’è il ragionamento nei modelli Gemini

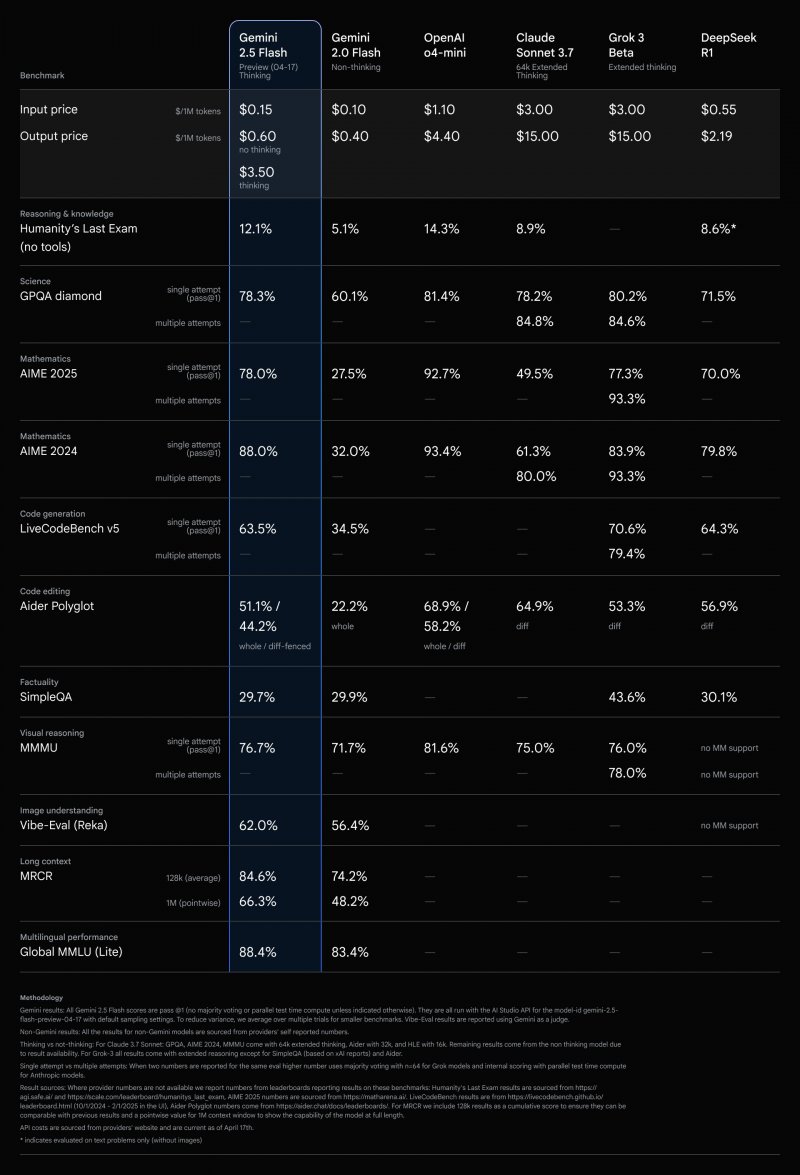

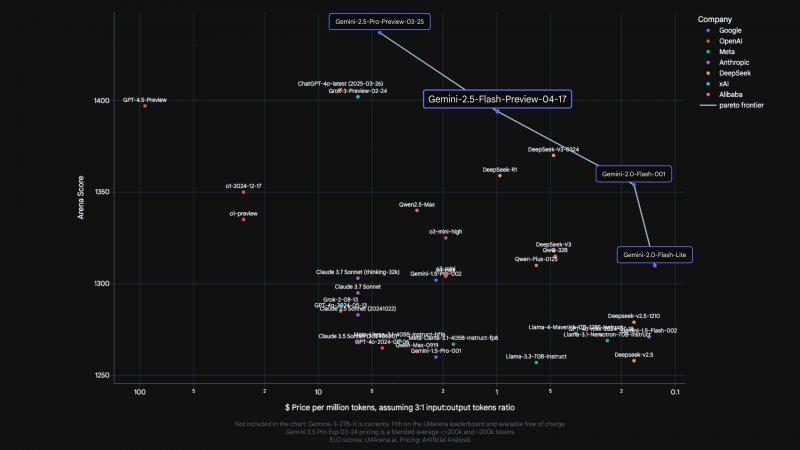

A differenza dei modelli tradizionali che generano una risposta immediata, Gemini 2.5 Flash è un modello "pensante", in grado di esaminare il prompt, analizzare il compito e pianificare una risposta prima di fornire l'output finale. Questo processo di thinking è particolarmente utile nei compiti a più passaggi, come problemi matematici, domande complesse di ricerca o generazione di codice. Secondo Google, il modello si comporta molto bene su test di complessità elevata (come quelli di LMArena), superato solo dal fratello maggiore Gemini 2.5 Pro.

La vera innovazione introdotta da 2.5 Flash è la possibilità per gli sviluppatori di impostare un thinking_budget, ovvero un limite massimo di token dedicati alla fase di ragionamento. Più alto è il budget, maggiore sarà la capacità del modello di esplorare il problema e generare risposte più sofisticate. Il valore può andare da 0 fino a 24.576 token, ma il modello non utilizzerà l'intero budget se il prompt non lo richiede.

Prestazioni e costi sotto controllo

Google definisce Gemini 2.5 Flash come il suo modello pensante più efficiente in termini di rapporto qualità-prezzo (a differenza invece di Gemini 2.5 Pro, che invece non bada a "spese"). Le prestazioni sono comparabili a quelle di modelli più costosi e voluminosi, pur mantenendo una dimensione e un costo più contenuti. Questo rende 2.5 Flash particolarmente adatto per applicazioni su larga scala, sviluppo software e ambienti in cui conta ogni millisecondo di latenza o ogni centesimo speso.

La versione preview è già disponibile per tutti gli sviluppatori tramite Google AI Studio, Vertex AI e nella nuova app Gemini attraverso un menu a tendina dedicato. Google consiglia di testare il parametro thinking_budget per personalizzare il comportamento del modello in base alle proprie necessità. I primi esempi di codice e le guide sono già consultabili nella Gemini Cookbook e nella documentazione ufficiale per sviluppatori.